奇异值分解(SVD)是线性代数中一种重要的矩阵分解方法,在数据压缩存储、搜索引擎、信号处理、统计学、动力学等领域有重要应用。在介绍奇异值分解之前,很有必要先介绍一下特征值分解。因为二者有着紧密的关联,特征值分解和奇异值分解的目的都是一样:提取出矩阵中最重要的特征。特征值和奇异值在大部分人的印象中,往往是停留在纯粹的数学计算中。而且在线性代数或者矩阵论里面,也很少讲任何跟特征值和奇异值有关的应用。奇异值分解是一个有着显著物理意义的一种方法,它可以将一个比较复杂的矩阵用更小更简单的几个子矩阵的相乘来表示,这些小矩阵包含原始矩阵重要的特征。

特征值分解及其物理意义

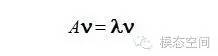

对一个M×M的方阵A和向量υ,如果存在λ使得下式成立

则称λ为矩阵A的的特征值,υ称为矩阵A的特征向量。一个矩阵的一组特征向量是一组正交向量。特征值分解是将一个矩阵分解成下面的形式

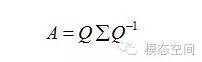

则称λ为矩阵A的的特征值,υ称为矩阵A的特征向量。一个矩阵的一组特征向量是一组正交向量。特征值分解是将一个矩阵分解成下面的形式

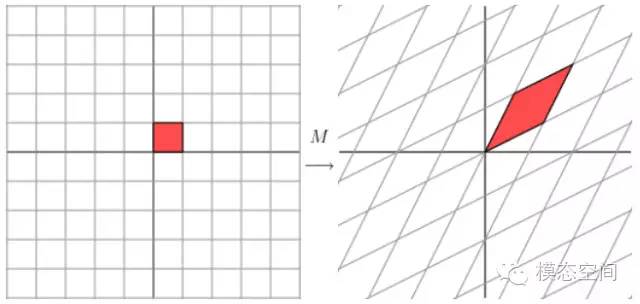

其中Q是这个矩阵A的特征向量组成的矩阵,Σ是一个对角阵,每一个对角线上的元素是一个特征值。首先,要明确的是,一个矩阵其实就是一个线性变换,因为一个矩阵乘以一个向量后得到的向量,其实就相当于将这个向量进行了线性变换。比如说下面的一个矩阵:

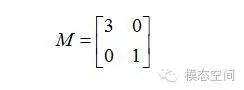

其中Q是这个矩阵A的特征向量组成的矩阵,Σ是一个对角阵,每一个对角线上的元素是一个特征值。首先,要明确的是,一个矩阵其实就是一个线性变换,因为一个矩阵乘以一个向量后得到的向量,其实就相当于将这个向量进行了线性变换。比如说下面的一个矩阵:

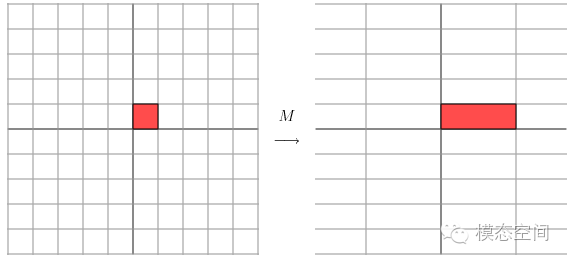

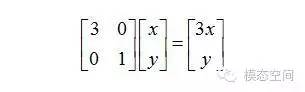

从几何上来说,我们可以认为一个二维向量是几何平面上的一点(x,y),通过矩阵M变换到另一点

从几何上来说,我们可以认为一个二维向量是几何平面上的一点(x,y),通过矩阵M变换到另一点

变换后的结果相当于乘以下图所示的变换,即水平方向乘以了因子3(长度拉伸了3倍),垂直方向不变化。

变换后的结果相当于乘以下图所示的变换,即水平方向乘以了因子3(长度拉伸了3倍),垂直方向不变化。

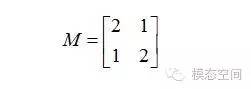

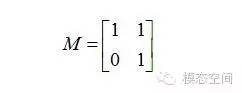

从上图来看,简单描述变换的几何效果不是很容易。然而,让我们将网格旋转45度,再来看发生了什么。

从上图来看,简单描述变换的几何效果不是很容易。然而,让我们将网格旋转45度,再来看发生了什么。

这个矩阵变换后得到的形状为剪切形。

这个矩阵变换后得到的形状为剪切形。 初看起来,这个网格不是正交的,但当对其旋转58.28度之后,两个网格都变成了正交网格。

初看起来,这个网格不是正交的,但当对其旋转58.28度之后,两个网格都变成了正交网格。

奇异值分解及其物理意义

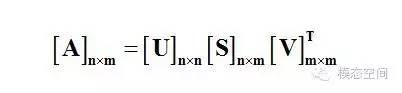

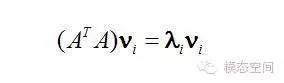

其中S=diag(σ1,σ2,……,σr),σi>0 (i=1,2…,r),r=rank(A)。得到的U是一个N×N的方阵(里面的向量是正交的,U里面的向量称为左奇异向量)。S是一个N×M的矩阵(非对角线的元素都是0,对角线上的元素称为奇异值),VT(是一个M×M的方阵,里面的向量也是正交的,V里面的向量称为右奇异向量)。 在对矩阵进行奇异值分解时,是通过特征值分解方法求得的,首先将矩阵转化为方阵,然后对其进行特征值分解。 假设对N×M的矩阵A进行奇异值分解,首先,我们将矩阵A左乘以它的转置矩阵AT,将会得到一个M×M方阵,我们用这个方阵求特征值可以得到:

其中S=diag(σ1,σ2,……,σr),σi>0 (i=1,2…,r),r=rank(A)。得到的U是一个N×N的方阵(里面的向量是正交的,U里面的向量称为左奇异向量)。S是一个N×M的矩阵(非对角线的元素都是0,对角线上的元素称为奇异值),VT(是一个M×M的方阵,里面的向量也是正交的,V里面的向量称为右奇异向量)。 在对矩阵进行奇异值分解时,是通过特征值分解方法求得的,首先将矩阵转化为方阵,然后对其进行特征值分解。 假设对N×M的矩阵A进行奇异值分解,首先,我们将矩阵A左乘以它的转置矩阵AT,将会得到一个M×M方阵,我们用这个方阵求特征值可以得到:

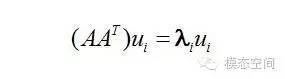

这里求得的υ就是上面的右奇异向量。 或者将我们将矩阵A右乘以它的转置矩阵AT,将会得到一个N×N方阵,我们用这个方阵求特征值可以得到:

这里求得的υ就是上面的右奇异向量。 或者将我们将矩阵A右乘以它的转置矩阵AT,将会得到一个N×N方阵,我们用这个方阵求特征值可以得到:

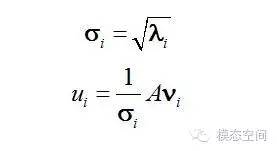

这里的σ就是上面所说的奇异值。u和υ分别是矩阵A的奇异向量,而S=diag(σ1,σ2,……,σr)是A的奇异值。AAT的正交单位特征向量组成U,特征值组成STS,ATA的正交单位特征向量组成V,特征值(与AAT相同)组成SST。也就是说,奇异值σ是矩阵特征值λ的非负平方根。因此,奇异值分解与特征值问题紧密相联。

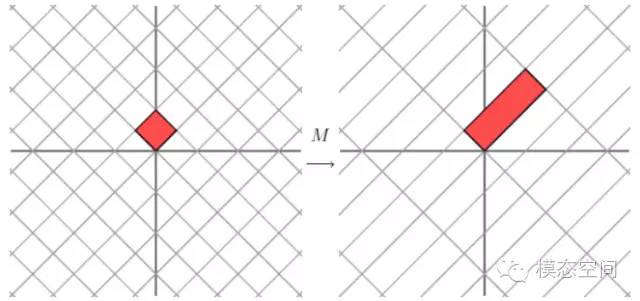

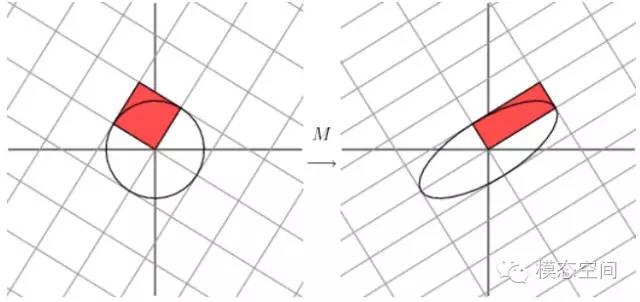

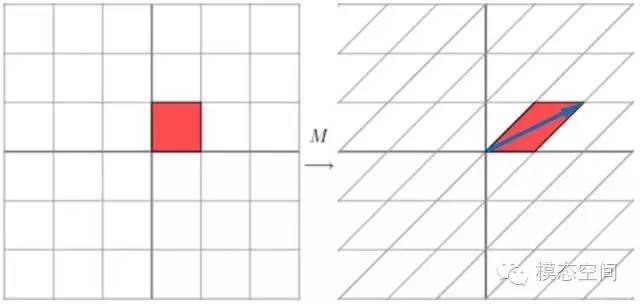

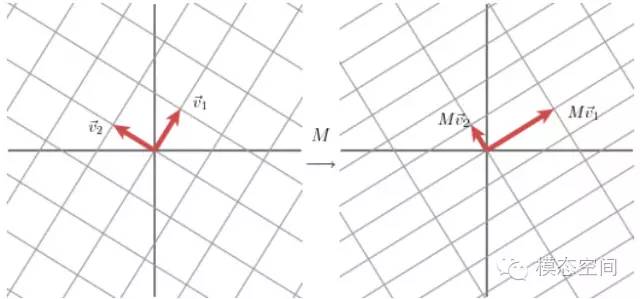

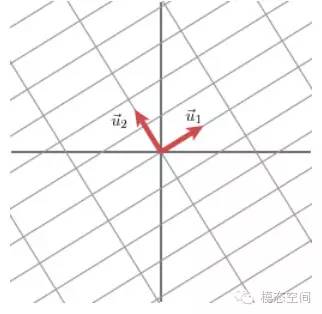

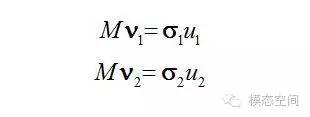

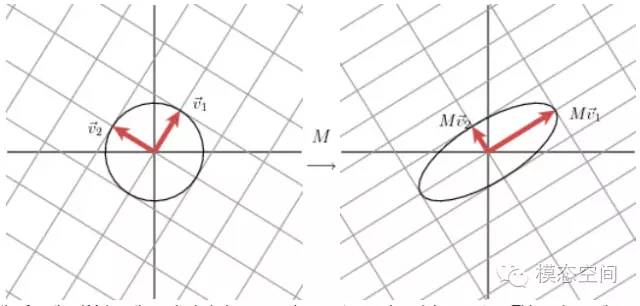

这里的σ就是上面所说的奇异值。u和υ分别是矩阵A的奇异向量,而S=diag(σ1,σ2,……,σr)是A的奇异值。AAT的正交单位特征向量组成U,特征值组成STS,ATA的正交单位特征向量组成V,特征值(与AAT相同)组成SST。也就是说,奇异值σ是矩阵特征值λ的非负平方根。因此,奇异值分解与特征值问题紧密相联。 向量u1和u2表示Mv1和Mv2方向上的单位向量。Mv1和Mv2的长度,用σ1和σ2表示,这些数就是矩阵M的奇异值,它表示的是在这两个特定的方向上网格被拉伸的幅度。

向量u1和u2表示Mv1和Mv2方向上的单位向量。Mv1和Mv2的长度,用σ1和σ2表示,这些数就是矩阵M的奇异值,它表示的是在这两个特定的方向上网格被拉伸的幅度。

我们有

我们有

换句话说,单位圆上的|Mx|在v1方向上有最大值,在v2方向上有最小值。这样就将问题简化为相当标准的微积分问题:我们希望在整个单位圆上优化函数。结果是这个函数的关键点出现在矩阵MTM的特征向量处。既然这个矩阵是对称阵,不同特征值对应的特征向量将是正交的。这些正交的向量是就vi。通过引入单位圆后的变换,我们就找到了变换后的主分量方向,即Mv1和Mv2方向,也就是向量u1和u2表示的方向。

换句话说,单位圆上的|Mx|在v1方向上有最大值,在v2方向上有最小值。这样就将问题简化为相当标准的微积分问题:我们希望在整个单位圆上优化函数。结果是这个函数的关键点出现在矩阵MTM的特征向量处。既然这个矩阵是对称阵,不同特征值对应的特征向量将是正交的。这些正交的向量是就vi。通过引入单位圆后的变换,我们就找到了变换后的主分量方向,即Mv1和Mv2方向,也就是向量u1和u2表示的方向。

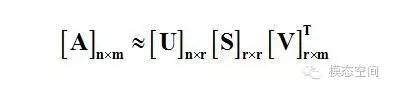

r是一个远小于m、n的数。右边的三个矩阵相乘的结果将会是一个接近于A的矩阵,在这儿,r越接近于m,则相乘的结果越接近于A。

奇异值分解与特征值分解的区别

转自 谭祥军 《模态空间》